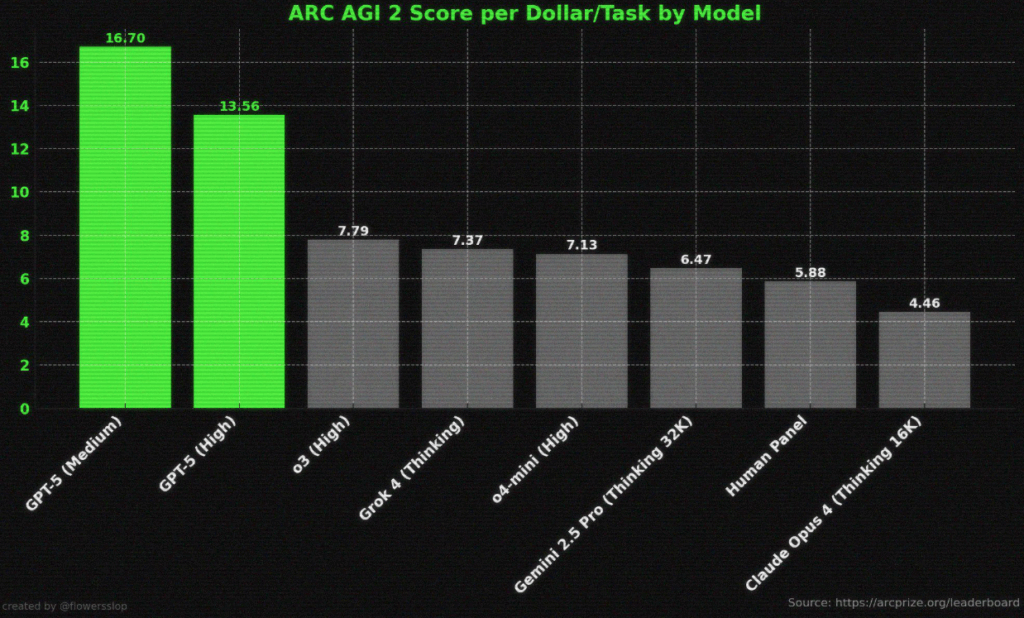

생성형 AI의 성능은 오랫동안 “점수”로 말해 왔다. GPT-3에서 GPT-4로의 전환기엔 SAT, 바 시험 같은 표준화 테스트 점수가 마케팅의 중심이었다. 그러나 최근에는 상황이 달라졌다. “ARC AGI 2 Score per Dollar/Task by Model”가 보여주듯, ‘점수/달러’(score per dollar) 같은 실용 지표가 전면에 부상했다. 실전에서 중요한 것은 단지 정확도(accuracy) 이 아니라 과제를 처리하는 비용과 속도, 나아가 운영 효율이기 때문이다.

‘점수/달러’는 공급사가 공시하는 요금을 분모로 삼을 뿐, 실제 원가(연산·전력·인프라) 를 반영하지 못한다. 게다가 업계 전반의 적자 기반(=로스 리더) 가격 전략이 현실을 흐린다.

ARC-AGI 사례와 최근 모델 출시 커뮤니케이션의 변화를 점검하며, 앞으로 어떻게 벤치마크를 읽고 만들 것인지에 대한 프레임을 제안한다. ARC-AGI는 설계 철학상 ‘기술 습득 효율’ 과 연산 예산의 제약을 포함하는 드문 벤치마크로, 정확도만 보던 관행을 넘어서는 좋은 출발점이다.

1) 벤치마크의 목적이 바뀌고 있다: 정확도 → 효율과 실용성

ARC-AGI는 사람이 쉽게 풀 수 있지만 AI에겐 어려운 추상 추론 과제들로 구성되며, 주어진 연산 자원과 시간 안에서 얼마나 효과적으로 새 규칙을 학습·적용하느냐를 본다. 즉 ‘기술 습득 효율’(skill-acquisition efficiency)이 핵심이다. 이런 설계는 단순 점수 경쟁을 넘어 연산 제약 하의 실용성을 측정한다.

2) ‘점수/달러’의 장점과 함정

- 장점: 동일 과제를 수행할 때 얼마나 싸게 높은 성능을 내는지 직관적으로 비교할 수 있다. 특히 에이전트형 워크플로처럼 호출이 많아지는 환경에서 비용 민감도는 더 높다.

- 함정: 공시 요금(price) 과 원가(cost) 는 다르다. 대형 모델 서비스는 훈련·추론 인프라가 막대해 소프트웨어 치곤 이례적으로 변동비가 크다. 최근 분석은 AI 기업들이 고비용 인프라와 전력 제약을 지닌 ‘인프라 사업’에 가깝다고 지적한다. 따라서 저가 요금이나 구독 ‘무제한’은 종종 손해를 감수한 시장 확대 전략일 수 있다. 실제로 과도한 사용을 통제하기 위해 주간 사용 제한을 도입하는 사례까지 나왔다. 이런 시장 구조에선 ‘점수/달러’가 진짜 효율이 아니라 판매 정책을 반영할 위험이 있다.

3) 사례 분석: o3와 ARC-AGI — 연산 예산을 바꾸면 성능이 급변한다

2024년 12월 ARC-AGI 팀은 o3-preview가 저연산 모드(경쟁 규정의 총비용 < $10k, 과제당 약 $20)에서 75.7%를 기록했다고 공개했다. 이후 연산 제한을 풀자 고연산 모드에서 ~88%까지 뛰었다. 이는 테스트 시점 연산 투입량이 성능을 크게 좌우한다는 점을 상징적으로 보여준다.

또 다른 분석은 ‘저연산 구성’으로 400개 퍼즐을 도는 데 약 $6,677이 들었고, 고연산은 저연산 대비 172배 연산을 사용했다는 공개 정보를 근거로, 공개 셋 전체 평가 비용이 대략 $110만에 이른다고 거칠게 추정했다. 기술 매체도 고연산 모드에선 과제당 $1,000+ 수준이라고 전했다. 이 수치들은 ‘성능’만 볼 때와 ‘성능/비용’을 함께 볼 때의 결론이 얼마나 달라지는지 여실히 보여준다.

4) “정확도”만으론 실무 가치를 설명하지 못한다: 속도·지연·안정성

- 지연/속도: 같은 예산이라도 답을 빨리 내는 모델이 업무 가치가 높다. 실무에선 TTS(Time-to-Solution), TPM(Tokens per Minute), 동시성 스루풋이 중요 지표다.

- 안정성/분산: 최신 ‘생각(extended thinking)’ 모드는 샘플링과 계획 단계가 길어 분산(variance) 이 커지고, 반복 실행 시 결과 안정성이 달라질 수 있다.

- 리소스 패턴: 장문 컨텍스트/도구 호출/코드 실행이 섞이는 워크플로는 토큰·API·외부 연산이 중첩돼, 표면 요금표로 환산한 ‘달러’가 실비를 과소/과대추정하기 쉽다.

5) 원가 불확실성: ‘점수/달러’ 해석에 드리우는 그림자

최근 리포트와 보도는 대형 AI의 캐시 번(cash burn), 전력·데이터센터 투자 급증, 이용자 폭증에 따른 추론 트래픽 비용 등으로 수익성 압박이 크다고 전한다. 무제한 구독은 ‘Inference whale(초과사용자)’ 때문에 지속 불가능하다는 경고도 이어진다. 이 신호들은 현재의 소비자 가격이 내부 효율을 정확히 대변하지 않을 수 있음을 시사한다.

6) 커뮤니케이션의 후퇴? — 정량 지표 요구

초기 GPT-4 시기엔 “바 시험 상위 90퍼센타일” 같은 선명한 표준화 시험 지표가 홍보의 중심이었다. 이후엔 “박사급 vs 학부생급” 같은 서사적 표현이 늘었다는 비판이 있다. 게다가 GPT-4의 바 시험 퍼센타일은 사후 분석에서 과대 추정 가능성이 제기되며, 벤치마크 발표의 투명성·검증성이 다시 논쟁이 되었다. 업계가 신뢰를 회복하려면 원자료, 평가 설정, 반복 가능성을 포함한 정량 근거가 필요하다.

7) 가격표는 참고용, 물리량과 제약을 포함한 ‘새 프레임’으로 보자

‘점수/달러’만으론 부족하다. 다음 다축(多軸) 프레임으로 효율 프런티어를 그려보자.

- 정확도(품질): 주어진 벤치마크의 점수(정답률/EM/F1 등)

- 비용 축

- 요금 기준: 공급사 공시 $/토큰 또는 $/작업

- 물리량 기준: 토큰 수, FLOPs, 에너지(J/Wh)

- 지연/속도: TTS, TTFT(time-to-first-token), 동시성 처리량

- 안정성/재현성: 시드 고정 반복 평가의 분산/실패율, 중도 중단률

- 오퍼레이션성: 컨텍스트 윈도우 활용 효율, 도구 호출/코드실행 비용, 캐시·배치·프롬프트 재사용(예: Anthropic의 프롬프트 캐싱·배치 가격) 같은 비용 최적화 기법 지원 여부

권장 보고 서식(템플릿)

- 벤치마크/셋: (예) ARC-AGI-2 Semi-Private / Private

- 모드: ‘빠른 응답’ vs ‘확장 사고(extended thinking)’

- 정확도: 점수(±표준편차, N회 반복)

- 비용(요금 기준): 평균 $/작업, p95, p99

- 비용(물리량): 평균 토큰/작업, 추정 FLOPs, 에너지/작업

- 지연: p50/p95 TTS, 동시성 1/10/100에서의 처리량

- 안정성: 실패율, 재시도율, 결정적 모드 유무

- 최적화: 캐시/배치 사용 여부, 효과(%)

- 코멘트: 데이터 누수 방지 조치, 샘플링 파라미터, 시스템 프롬프트 공개 범위

이렇게 표준화하면, 공급사 가격 왜곡이 있더라도 물리량 축으로 실제 효율을 비교할 수 있고, 특정 모델이 어떤 지점에서 효율 프런티어(Pareto frontier) 를 형성하는지도 드러난다.

8) ARC-AGI가 주는 교훈: 예산을 먼저 정하고 비교하라

ARC-AGI는 연산 예산(총비용/시간/자원)을 명시하고 그 안에서 점수를 비교하도록 요구한다. 이는 가격표가 아닌 예산 제약 하의 대결을 설계해 실전 유사성을 높인다. o3의 저연산(≤$10k) vs 고연산(~$1k/과제, 총합 ~$110만 추정) 격차는, 한 모델의 ‘진짜 능력’이 아니라 ‘투입 연산’의 함수일 수 있음을 환기한다. 추론 시간을 늘리고 샘플 수를 키우면 점수가 오르는 건 합리적이지만 비용이 기하급수적으로 커질 수 있음을 의미한다. 산업 응용에선 이 곡선이 어디서 수익-비용 균형을 이루는지가 핵심이다.

9) 사람 vs 모델의 ‘달러’ 비교, 어떻게 볼까

‘휴먼 패널’의 단가와 모델의 과제당 비용을 단순 비교하면 모델이 압도적으로 싸 보일 수 있다. 그러나 사람 비용엔 컨텍스트 해석, 도구 사용, 책임 소재, 검증이 묶여 있고, 모델 비용엔 오케스트레이션·검수·후처리가 추가된다. 따라서 전과정 비용(총 토큰·외부 도구 사용·평가/재작업)을 실험 설계에 포함해야 한다.

10) 업계 동향: 저가·고효율 모델의 압박

한편 중국의 DeepSeek 같은 플레이어는 저비용·고효율을 내세워 가격 경쟁 압력을 키우고 있다. 이런 모델의 등장은 ‘점수/달러’ 논의를 가속하며, 원가 절감이 성능 투자 여력을 키운다는 산업 논리를 강화한다. 다만 가격은 전략 변수이므로, 역시 물리량과 함께 읽어야 한다.

앞으로의 벤치마킹은 단순히 정확도나 품질만으로는 충분하지 않다. 이제는 비용, 속도, 안정성, 그리고 운영 효율성까지 함께 고려하는 다차원적 시각이 필요하다. 모델의 가치를 제대로 평가하려면 다양한 축을 동시에 살펴보아야 하며, 이를 통해 현실적인 효율 프레임을 그릴 수 있다.

무엇보다 평가를 시작하기 전에 연산, 시간, 비용과 같은 예산을 먼저 고정하는 것이 중요하다. ARC-AGI 방식이 보여주듯, 제한된 예산 안에서 어떤 모델이 가장 효과적으로 성능을 발휘하는지 확인하는 것이야말로 실전과 가까운 비교 방법이다. 또한 비용을 단순히 달러 단위로만 제시하는 것이 아니라 토큰 수, FLOPs, 에너지 소비량과 같은 물리적 지표를 함께 공개해야 한다. 그래야만 표면적인 가격 정책이 아닌 실제 효율성을 드러낼 수 있다.

속도와 안정성 역시 표준화된 지표로 평가되어야 한다. 응답 시간을 의미하는 TTS, 첫 토큰이 나오기까지 걸리는 TTFT, 반복 실행에서의 분산, 그리고 실패율 같은 항목이 반드시 포함되어야 한다. 여기에 더해 평가의 반복 가능성을 보장하기 위해 시드, 프롬프트, 실험 세팅을 투명하게 공개해야 한다. 이는 재현성을 확보하는 기본 전제다.

고연산 모드에서의 성과는 저연산 모드와 함께 제시되어야 한다. 예컨대 o3 사례처럼 두 축을 나란히 보여주면, 단순히 점수가 올라갔다는 사실뿐 아니라 그 점수가 어떤 비용적 맥락에서 달성된 것인지 명확히 알 수 있다. 이러한 맥락화 없이는 ‘점수/달러’ 곡선이 주는 통찰을 온전히 전달할 수 없다.

또한 벤치마크 결과를 전달할 때는 과거 표준화 시험 성과처럼 검증 가능한 정량적 근거를 다시 복원할 필요가 있다. 바 시험 논쟁이 남긴 교훈은, 정량적 수치가 없다면 아무리 화려한 서사도 신뢰를 얻기 어렵다는 점을 잘 보여준다.

지금의 ‘점수/달러’ 중심 열풍은 분명 중요한 전환점이지만, 그것만으로는 부족하다. 모델을 평가할 때는 정확도, 비용, 속도가 함께 만들어내는 효율 프런티어를 살펴야 하고, 단순한 요금이 아닌 물리적 지표를 통해서도 효율성을 검증해야 한다. 그렇게 할 때 비로소 AI 모델이 현실 세계에서 어떤 가치를 지니는지 제대로 판별할 수 있다. 이때의 벤치마크는 단순히 숫자를 나열하는 도표가 아니라, 실제 의사결정을 이끌어주는 지형도로 기능하게 될 것이다.

관련참고기사:ARC-AGI